Les promesses du hasard

08.10.2018Le hasard n’a pas d’habitudes. Aussi contrecarre-t-il toute loi déterministe dont la connaissance permet de prévoir un effet à partir d’une cause. Irrégulier, le hasard semble mu par caprices. Or il n’est pas imprévisible : voilà la fonction des probabilités et autres calculs stochastiques.

Le langage courant ne quantifie jamais l’incertain. Des adjectifs l’évaluent vaguement, de l’impossible au certain en passant par l’invraisemblable, le douteux, le plausible. Pas d’échelle dans ce qu’on ne sait prévoir mais une petite bande de synonymes qui tablent à parts égales sur le flou : fortuit, éventuel, aléatoire, hasardeux, casuel, imprévu, inattendu, contingent… Or dans la béance de cette part égale se jettent d’irrationnelles croyances, de l’optimiste au pessimiste, de la foi en sa chance à la certitude d’être maudit, et d’autres créances dont la rationalité fait mystère de ses preuves, comme la justice divine, la loi du karma, puis enfin des superstitions et toutes sortes de prières et rites propices pour favoriser la « Fortune », cette divinité dont on peine à savoir assurément quels mérites favorisent ses récompenses…

Car lorsqu’on s’assure que demain nous prendrons un café ensemble, l’on parle de l’assurance de notre intention, mais il y a loin de celle-ci au café ! Entre l’intention ferme et le café fumant est une part aléatoire. Et probablement rien ne procède sans quotient d’incertitude. « Rien n’est jamais sûr » murmure-t-on en baissant la tête, « si Dieu le veut », pense-t-on en levant les yeux au ciel. A titre individuel comme collectif, l’on évalue mal à quel point ceci est rassurant !

Mais ceci est sans compter l’appréciation mathématique de la réalité… La probabilité est alors cette grandeur numérique qui quantifie par un pourcentage le caractère aléatoire d’un évènement. Et la théorie des probabilités et la statistique sont des branches des mathématiques étudiant les phénomènes caractérisés par le hasard et l’incertitude. « Rien n’est plus glorieux que de pouvoir donner des règles à des choses, qui, étant dépendantes du hasard, semblent n’en connaître aucune, et par là, se soustraire à la raison humaine. » écrivit Christian Huygens (1629-1695).

C’est là une vieille histoire, que ne peuvent narrer que ceux qui la comprennent… Aussi n’en dirons-nous que le moins possible. On attribue au échanges entre Blaise Pascal (1623-1662) et Pierre de Fermat ( ?-1665) l’origine du calcul des probabilités d’un problème. Puis les philosophes, mathématiciens, naturalistes, botanistes, chimistes et physiciens… tous s’y collèrent, chacun dans son domaine : l’estimation de l’aléa est au cœur de la connaissance, qui seule permet de fonder une prévisibilité.

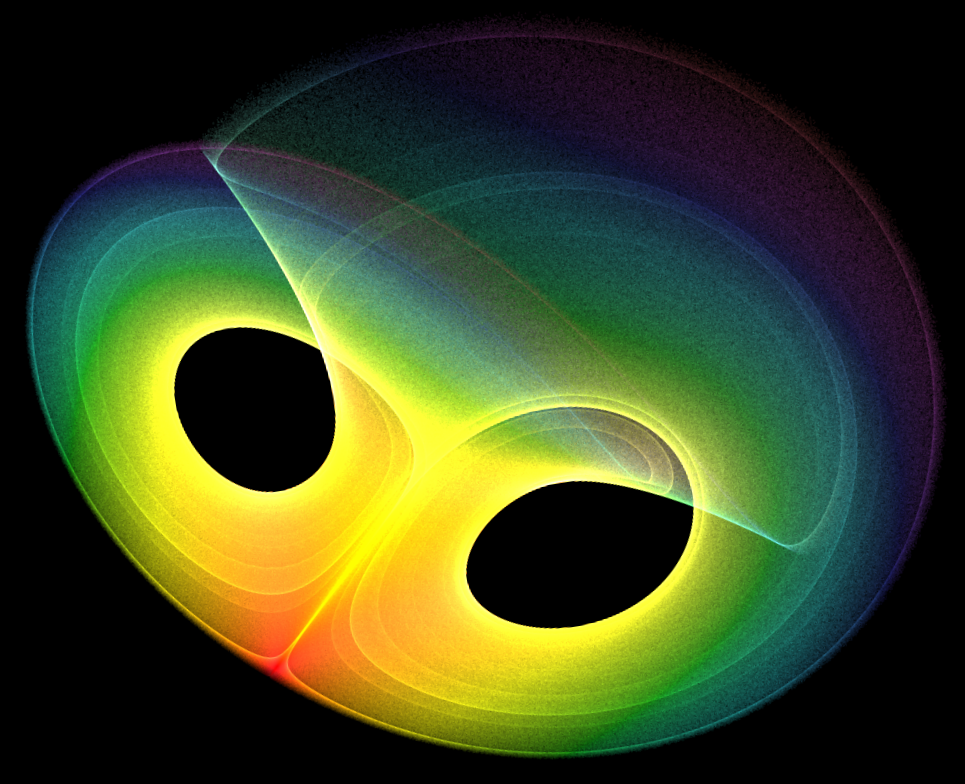

La description mathématique du mouvement aléatoire proposée par le botaniste Robert Brown (1773-1858), semble avoir été une pierre de touche dans cette quête : ce mouvement brownien sera étudié par les plus grands savants, parmi lesquels Albert Einstein (1879-1955) ou Paul Langevin (1872-1946). Il est à l’origine du calcul stochastique qui étudie les phénomènes aléatoires dans le temps, où les noms d’A. A. Markov (1856-1922), de Kyoshi Itõ (1915-2008) et de Norbert Wiener (1894-1964), fondateur de la cybernétique, la théorie de l’information et de l’organisation, reviennent souvent parmi ceux des mathématiciens qui s’y distinguèrent. Ce calcul stochastique est donné comme une extension particulière de la théorie des probabilités, dont on attribue la première modélisation mathématique à N. Kolmogorov (1903-1987), et qui n’a cessé de se développer et se complexifier au cours d’expérimentations dans d’autres champs de recherche, à commencer par celui de la mécanique quantique, qui étudie les phénomènes physiques de comportement des particules à l’échelle atomique et subatomique, particulièrement avec l’équation du physicien Erwin Schrödinger (1887-1961). Ces grands noms cités ne le seraient sans leurs pairs : il s’agit d’un vaste réseau d’intelligence humaine qui œuvre, tâtonne, découvre, infirme, confirme, remet en question, refonde de nouvelles bases, en se passant le relais. Tous sont la grande aventure vivante de la recherche d’un savoir rationnel et expérimental. Or ce savoir doit comprendre et prévoir le hasard.

Ce survol grossier de l’histoire de la modélisation du hasard doit citer la fameuse « machine de Turing », cet outil conceptuel pensé par Allan Turing (1912-1954) en 1936, ainsi que les mathématiciens John Von Neumann (1903-1957), et Claude Shannon (1916-2001). Avec le précité Norbert Wiener, ces cerveaux extraordinaires ont les premiers pensé et posé les bases de la modélisation du rapport entre mathématique, technologie et information. Ils sont les têtes de proue de l’invention de l’informatique, et Shannon reste l’inventeur du bit toujours en vigueur, cet élément binaire qui est l’unité de mesure de l’information en informatique. Or la notion de quantité d’information se fonde sur la probabilité, où l’information est la mesure d’une incertitude calculée à partir de la probabilité d’un évènement.

Par-delà la mécanique quantique, les domaines d’application des probabilités s’étendent à la chimie, la météorologie, les mathématiques financière, le traitement d’images… Ces champs se recoupent avec la mathématique statistique et le traitement algorithmique des données, depuis les sciences de la nature (la physique, la biologie…) jusqu’aux sciences de la vie et de la culture – médecine, économie, environnement, démographie, sociologie, sciences politiques,… Nul champ théorique ou pratique n’en fait l’économie. A l’ère de l’Intelligence Artificielle, dont le « Big Data » de collecte, de stockage et de traitement analytique de bases de données numériques d’un volume jusqu’alors inconnu dans l’histoire de l’humanité, il apparait que tous les champs de savoir théorique comme appliqué travaillent à réduire l’imprévisibilité et l’imprédictibilité. La loi des grands nombres et la théorie du chaos réduisent le hasard en lois probabilistes, autorisant des projections plus rigoureuses du futur et des agissements de chacun. Les caprices comportementaux sont « somme toute » – ou quantitativement – modélisables…

Ce principe d’incertitude mathématisé dans les sciences devient peu à peu un idéal de régulation des activités humaines, particulièrement quand celles-ci sont numériquement traçables, et représentent autant de données et d’informations à traiter, corréler et mesurer. Connaître, calculer, comprendre, conjecturer, canaliser puis contrôler, le hasard de chacun a son quotient de chances d’être conformé aux règles communes de populations appréhendées en masses. Peut-on prévoir le flocon qui décidera de l’avalanche ? Si c’est possible et qu’on le supprime, peut-on prévoir et neutraliser tous les flocons menaçant afin d’empêcher cette avalanche ? (dialogue entre J. von Neumann et R Wiener). En d’autres termes, la compréhension des sociétés serait-elle réductible à la science météorologique ? Certains l’espèrent et y œuvrent. Personne ne semble pourtant connaître la date et l’heure du prochain krach boursier.

Si l’on prévoit le hasard, ce dernier restera toujours ce qu’on n’avait pas prévu. Le paradoxe serait de vouloir éradiquer tout hasard, associé par étymologie au jeu et au risque, quand il semble que toutes les lois de l’Univers, et jusqu’à la causalité même, procèdent de son principe créateur et dynamique.